Immagina un gioco in cui poter avere conversazioni intelligenti, non scriptate e dinamiche con personaggi non giocabili (NPC) dalle peculiari personalità che si evolvono nel tempo, unite ad animazioni ed espressioni facciali accurate, il tutto nella tua lingua madre.

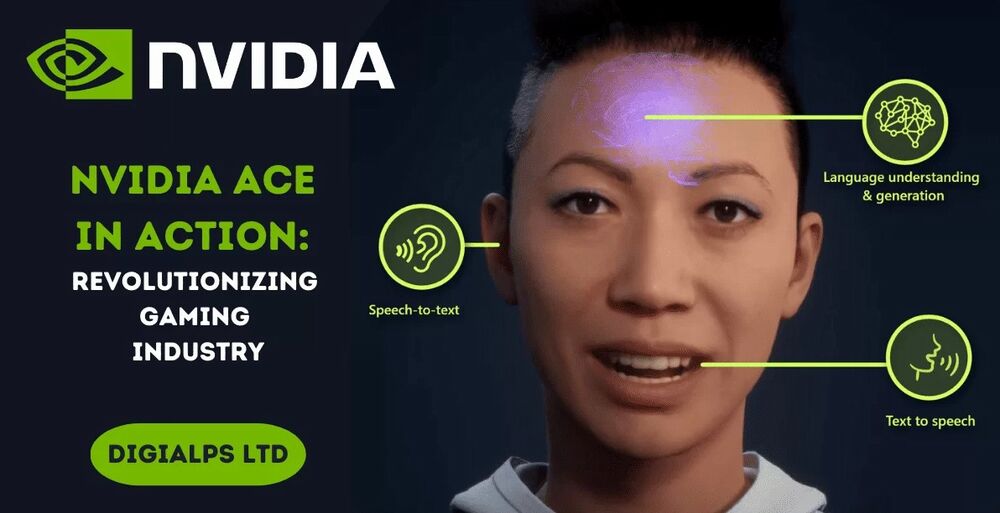

Le tecnologie di intelligenza artificiale generativa stanno rendendo tutto questo realtà ed NVIDIA sta lavorando al futuro degli NPC con l'Avatar Cloud Engine (ACE) per i giochi. NVIDIA ACE è un servizio di creazione di modelli di intelligenza artificiale personalizzati che mira a trasformare i giochi portando intelligenza gli NPC tramite interazioni di linguaggio naturale basate sull'intelligenza artificiale.

"L'intelligenza artificiale generativa ha il potenziale per rivoluzionare l'interattività che i giocatori possono avere con i personaggi dei giochi e aumentare drasticamente l'immersione nei giochi", ha affermato John Spitzer, vicepresidente della tecnologia per sviluppatori e prestazioni di NVIDIA. "Basandosi sulla nostra competenza nell'intelligenza artificiale e su decenni di esperienza di lavoro con gli sviluppatori di giochi, NVIDIA sta guidando l'uso dell'intelligenza artificiale generativa nei giochi".

Gli sviluppatori di middleware, strumenti e giochi possono utilizzare NVIDIA ACE for Games per creare e distribuire modelli AI personalizzati per discorso, conversazione e animazione nei loro software e giochi su cloud e PC.

I modelli di base AI ottimizzati includono:

Questa di seguito è una prima occhiata alla demo NVIDIA Kairos:

"Con NVIDIA ACE per i giochi, gli strumenti di Convai possono raggiungere la latenza e la qualità necessarie per rendere i personaggi AI non giocabili disponibili a quasi tutti gli sviluppatori in modo economicamente conveniente", ha affermato Purnendu Mukherjee, fondatore e CEO di Convai.

La demo di Kairos ha sfruttato NVIDIA Riva per le capacità di conversione da voce a testo e da testo a voce, NVIDIA NeMo per alimentare l'intelligenza artificiale conversazionale e Audio2Face per l'animazione facciale basata sull'intelligenza artificiale tramite input vocali. Questi moduli sono stati integrati senza soluzione di continuità nella piattaforma di servizi Convai e inseriti in Unreal Engine 5 e MetaHuman per dare vita a Jin.

Jin e la sua scena nel Ramen Shop sono stati creati dal team artistico di NVIDIA Lightspeed Studios e renderizzati interamente in Unreal Engine 5, utilizzando NVIDIA RTX Direct Illumination (RTXDI) per l'illuminazione e le ombre con ray tracing e DLSS per i frame rate e la qualità delle immagini più elevati possibili. Questa dimostrazione in tempo reale rivela cosa è possibile fare utilizzando le schede grafiche GeForce RTX, le tecnologie NVIDIA RTX e NVIDIA ACE per i giochi ed esemplifica le possibilità per i prossimi giochi che sfruttano questa tecnologia rivoluzionaria.

Sviluppatori di giochi e startup stanno già utilizzando le tecnologie di intelligenza artificiale generativa di NVIDIA. Ad esempio, GSC Game World sta utilizzando Audio2Face nell'attesissimo S.T.A.L.K.E.R. 2 Heart of Chornobyl. E lo sviluppatore indipendente Fallen Leaf sta utilizzando Audio2Face per l'animazione facciale dei personaggi in Fort Solis, il loro thriller fantascientifico in terza persona ambientato su Marte. Inoltre, Charisma.ai, un'azienda che abilita i personaggi virtuali tramite AI, sta sfruttando Audio2Face per alimentare l'animazione nel loro motore di conversazione.

Di fatto questo rappresenta un passo in avanti molto importante nel mondo dei videogiochi. L'idea di avere un dialogo interattivo, credibile e sempre diverso con ogni NPC del gioco, fa in modo che ogni avventura sia unica e che l'immedesimazione nel mondo di gioco diventi totale. Nel 2025 il videogioco Mecha Break dovrebbe comunque essere il primo in grado di sfruttare appieno le nuove funzioni dedicate agli NPC. Vi mostriamo qui il modo in cui gli sviluppatori di questo titolo hanno integrato la nuova tecnologia, con questo video uscito da pochissimi giorni:

Tuttavia questa impressionante evoluzione, parliamo addirittura del riconoscimento dei segnali non verbali del giocatore - qualora si fosse ripresi da una webcam - fa nascere anche qualche dilemma di tipo etico: finora c'è sempre stata una certa distanza tra gioco e realtà, tra NPC e persone vere ed assottigliare sempre più questa linea di confine rischia davvero di trascinare i giocatori in un vero e proprio mondo alternativo a quello reale, soprattutto se si tratta di ragazzi molto giovani che avrebbero invece bisogno di confrontarsi con i propri pari. Non c'è dubbio che avere dei compagni virtuali che in game reagiscono emotivamente, si adattano al giocatore, creano delle connessioni forti con il PG (personaggio giocante), possa essere assolutamente appagante per chi la sperimenta; mettendo le giuste limitazioni affinché queste interazioni non diventino eccessivamente totalizzanti, è fuori discussione che questa tecnologia apra le porte alla possibilità di vivere storie ancora più uniche e coinvolgenti.

Non abbiamo però ancora toccato il tasto, senz'altro possibile, dell’innesto di meccaniche narrative generate proceduralmente rispondendo a determinati input (o scelte) del giocatore, implementazione che andrebbe ulteriormente a restringere il lavoro creativo umano; a tal proposito un'altra domanda da porsi potrebbe riguardare quanto dello sviluppo (inteso come dipanamento della trama nel corso della partita) di un titolo single player verrebbe lasciato alla "fantasia" dell'IA. Da Metal Gear Solid a Final Fantasy VII, passando per Mass Effect e The Last of Us, tutti noi possiamo ben ricordare titoli con storie memorabili e coinvolgenti e personaggi secondari con cui abbiamo sentito di aver stretto un legame; ciò che li accomuna è che finora è stata l'abilità degli scrittori a determinare queste connessioni, proprio come possiamo empatizzare con i personaggi di un film o un libro. Lasciare gran parte di questi eventi nelle mani di un'intelligenza artificiale avrebbe reso migliore o peggiore l'esperienza con i videogames citati prima? Certo è impossibile rispondere oggi ed è altrettanto ovvio che la tecnologia andrà raffinata e migliorata affinché diventi un plus alla narrazione ed all'immedesimazione, non semplicemente un modo per realizzare meno righe di testo che verranno poi generate casualmente da ACE.

Non spetta agli sviluppatori risolvere i problemi di "dipendenza" che possono nascere da questa nuova tecnologia e lo stesso vale per tutti gli altri dilemmi più o meno etici come quello della privacy; a loro spetta però saper integrare sapientemente l'uso dell'intelligenza artificiale con la creatività e l'esperienza umana che ci ha garantito secoli di storie avvincenti, prima orali, poi su carta, al cinema ed oggi anche nei videogiochi. Cosa ne pensate? Siete più affascinati o più spaventati, dall'avvento di ACE?

Fonte Consultata

Le tecnologie di intelligenza artificiale generativa stanno rendendo tutto questo realtà ed NVIDIA sta lavorando al futuro degli NPC con l'Avatar Cloud Engine (ACE) per i giochi. NVIDIA ACE è un servizio di creazione di modelli di intelligenza artificiale personalizzati che mira a trasformare i giochi portando intelligenza gli NPC tramite interazioni di linguaggio naturale basate sull'intelligenza artificiale.

"L'intelligenza artificiale generativa ha il potenziale per rivoluzionare l'interattività che i giocatori possono avere con i personaggi dei giochi e aumentare drasticamente l'immersione nei giochi", ha affermato John Spitzer, vicepresidente della tecnologia per sviluppatori e prestazioni di NVIDIA. "Basandosi sulla nostra competenza nell'intelligenza artificiale e su decenni di esperienza di lavoro con gli sviluppatori di giochi, NVIDIA sta guidando l'uso dell'intelligenza artificiale generativa nei giochi".

Gli sviluppatori di middleware, strumenti e giochi possono utilizzare NVIDIA ACE for Games per creare e distribuire modelli AI personalizzati per discorso, conversazione e animazione nei loro software e giochi su cloud e PC.

I modelli di base AI ottimizzati includono:

- NVIDIA NeMo, che fornisce modelli linguistici di base e strumenti di personalizzazione, in modo che gli sviluppatori possano ulteriormente perfezionarli ed adattarli ai personaggi dei giochi. Questo modello linguistico di grandi dimensioni (LLM) personalizzabile consente retroscena e personalità specifiche dei personaggi che si adattano al mondo di gioco di uno sviluppatore. Gli sviluppatori possono allineare meglio le interazioni dei giocatori nel contesto di una scena tramite regole programmabili per i PNG con NeMo Guardrails.

- NVIDIA Riva, che fornisce funzionalità di riconoscimento vocale automatico (ASR) e di conversione del testo in voce (TTS) per abilitare la conversazione vocale in tempo reale con NVIDIA NeMo.

- NVIDIA Omniverse Audio2Face, che crea istantaneamente un'animazione facciale espressiva per i personaggi dei giochi da una semplice sorgente audio. Audio2Face presenta connettori Omniverse per Unreal Engine 5, così gli sviluppatori possono aggiungere animazioni facciali direttamente ai personaggi MetaHuman.

Questa di seguito è una prima occhiata alla demo NVIDIA Kairos:

"Con NVIDIA ACE per i giochi, gli strumenti di Convai possono raggiungere la latenza e la qualità necessarie per rendere i personaggi AI non giocabili disponibili a quasi tutti gli sviluppatori in modo economicamente conveniente", ha affermato Purnendu Mukherjee, fondatore e CEO di Convai.

La demo di Kairos ha sfruttato NVIDIA Riva per le capacità di conversione da voce a testo e da testo a voce, NVIDIA NeMo per alimentare l'intelligenza artificiale conversazionale e Audio2Face per l'animazione facciale basata sull'intelligenza artificiale tramite input vocali. Questi moduli sono stati integrati senza soluzione di continuità nella piattaforma di servizi Convai e inseriti in Unreal Engine 5 e MetaHuman per dare vita a Jin.

Jin e la sua scena nel Ramen Shop sono stati creati dal team artistico di NVIDIA Lightspeed Studios e renderizzati interamente in Unreal Engine 5, utilizzando NVIDIA RTX Direct Illumination (RTXDI) per l'illuminazione e le ombre con ray tracing e DLSS per i frame rate e la qualità delle immagini più elevati possibili. Questa dimostrazione in tempo reale rivela cosa è possibile fare utilizzando le schede grafiche GeForce RTX, le tecnologie NVIDIA RTX e NVIDIA ACE per i giochi ed esemplifica le possibilità per i prossimi giochi che sfruttano questa tecnologia rivoluzionaria.

Sviluppatori di giochi e startup stanno già utilizzando le tecnologie di intelligenza artificiale generativa di NVIDIA. Ad esempio, GSC Game World sta utilizzando Audio2Face nell'attesissimo S.T.A.L.K.E.R. 2 Heart of Chornobyl. E lo sviluppatore indipendente Fallen Leaf sta utilizzando Audio2Face per l'animazione facciale dei personaggi in Fort Solis, il loro thriller fantascientifico in terza persona ambientato su Marte. Inoltre, Charisma.ai, un'azienda che abilita i personaggi virtuali tramite AI, sta sfruttando Audio2Face per alimentare l'animazione nel loro motore di conversazione.

Di fatto questo rappresenta un passo in avanti molto importante nel mondo dei videogiochi. L'idea di avere un dialogo interattivo, credibile e sempre diverso con ogni NPC del gioco, fa in modo che ogni avventura sia unica e che l'immedesimazione nel mondo di gioco diventi totale. Nel 2025 il videogioco Mecha Break dovrebbe comunque essere il primo in grado di sfruttare appieno le nuove funzioni dedicate agli NPC. Vi mostriamo qui il modo in cui gli sviluppatori di questo titolo hanno integrato la nuova tecnologia, con questo video uscito da pochissimi giorni:

Tuttavia questa impressionante evoluzione, parliamo addirittura del riconoscimento dei segnali non verbali del giocatore - qualora si fosse ripresi da una webcam - fa nascere anche qualche dilemma di tipo etico: finora c'è sempre stata una certa distanza tra gioco e realtà, tra NPC e persone vere ed assottigliare sempre più questa linea di confine rischia davvero di trascinare i giocatori in un vero e proprio mondo alternativo a quello reale, soprattutto se si tratta di ragazzi molto giovani che avrebbero invece bisogno di confrontarsi con i propri pari. Non c'è dubbio che avere dei compagni virtuali che in game reagiscono emotivamente, si adattano al giocatore, creano delle connessioni forti con il PG (personaggio giocante), possa essere assolutamente appagante per chi la sperimenta; mettendo le giuste limitazioni affinché queste interazioni non diventino eccessivamente totalizzanti, è fuori discussione che questa tecnologia apra le porte alla possibilità di vivere storie ancora più uniche e coinvolgenti.

Non abbiamo però ancora toccato il tasto, senz'altro possibile, dell’innesto di meccaniche narrative generate proceduralmente rispondendo a determinati input (o scelte) del giocatore, implementazione che andrebbe ulteriormente a restringere il lavoro creativo umano; a tal proposito un'altra domanda da porsi potrebbe riguardare quanto dello sviluppo (inteso come dipanamento della trama nel corso della partita) di un titolo single player verrebbe lasciato alla "fantasia" dell'IA. Da Metal Gear Solid a Final Fantasy VII, passando per Mass Effect e The Last of Us, tutti noi possiamo ben ricordare titoli con storie memorabili e coinvolgenti e personaggi secondari con cui abbiamo sentito di aver stretto un legame; ciò che li accomuna è che finora è stata l'abilità degli scrittori a determinare queste connessioni, proprio come possiamo empatizzare con i personaggi di un film o un libro. Lasciare gran parte di questi eventi nelle mani di un'intelligenza artificiale avrebbe reso migliore o peggiore l'esperienza con i videogames citati prima? Certo è impossibile rispondere oggi ed è altrettanto ovvio che la tecnologia andrà raffinata e migliorata affinché diventi un plus alla narrazione ed all'immedesimazione, non semplicemente un modo per realizzare meno righe di testo che verranno poi generate casualmente da ACE.

Non spetta agli sviluppatori risolvere i problemi di "dipendenza" che possono nascere da questa nuova tecnologia e lo stesso vale per tutti gli altri dilemmi più o meno etici come quello della privacy; a loro spetta però saper integrare sapientemente l'uso dell'intelligenza artificiale con la creatività e l'esperienza umana che ci ha garantito secoli di storie avvincenti, prima orali, poi su carta, al cinema ed oggi anche nei videogiochi. Cosa ne pensate? Siete più affascinati o più spaventati, dall'avvento di ACE?

Fonte Consultata

Le stesse cose di oggi.

Nell'articolo si preconfigurano giochi come quelli ODIERNI ma con esperienze PARZIALMENTE diverse per ogni giocatore, inserendo variabili legate al singolo momento di gioco, come lo sono i labirinti automatici ad esempio ma col vantaggio che la variabilità non sarà (solo) casuale ma anche definita da principi e regole "logiche" che rientrano nel concetto di "intelligenza artificiale".

L'NPC Y del gioco X sarà sempre creato e definito dallo sviluppatore seguendo un binario principale definito, semplicemente al suo interno avrà una molto più grande libertà di manovra.

Opinione personale: la creatività di chi scrive la trama e la fantasia nel creare dinamiche di gioco innovative, mi viene in mente subito RDR2 con John che urla Chelonia se compie una determinata azione (chi lo sa, lo sa)... Bellissimo. Per me sono queste le perle che rendono un titolo indimenticabile.

Tradotto semplice: senza fare lavoro di fino sarà sempre garbage in, garbage out.

Di intelligenza non ha nulla. E lo dice uno che è al 100% a favore di questa roba.

Facendo un esempio a tema 'animeclick', visto che siamo qua, è come se qualcuno inventasse una tecnologia per variare gli sfondi di un anime ogni volta che lo guardi, modificando tipi e disposizioni di piante e fiori, o i vestiti delle persone che passano dietro i protagonisti etc. Tutto bellissimo, ok... ma davvero non ci sono altre priorità?

E, mi accodo alla precisazione di zazza... anche io sono a favore delle AI, ma credo si possano usare meglio per altro, almeno per ora.

Tutto uguale?

Le promesse sono proprio l'opposto.

Poi si sta parlando di una scienza e di una tecnologia (l'informatica e l'IA) che sono, relativamente, molto giovani.

Cose che noi oggi diamo per scontato pochi decenni or sono erano considerate quasi fantasia.

Probabilmente prima del 2030 l'IA nei videogiochi sarà la normalità e non farà nemmeno notizia.

Inizieremo adesso con videogiochi parzialmente prodotti con l'ausilio di IA, passeremo brevemente a videogiochi fatti quasi interamente con IA (dispiace per i programmatori), e finiremo con videogiochi che implementano al loro interno la IA per esperienze di gioco "aumentate" che poi diventeranno "infinite".

L'unica domanda è il tempo che ci impiegheremo per raggiungere ciò.

E chi le programma le IA?

Devi eseguire l'accesso per lasciare un commento.